Vi har i mange år været vant til at automatisere processer, der ikke krævede det, vi opfatter som menneskelig viden, erfaring og intelligens. Det er ved at ændre sig i disse år, hvor computerdrevne systemer i stigende grad bliver taget i anvendelse på områder, der tidligere var forbeholdt mennesker. Risikovurdering i forsikringsbranchen, kreditvurdering i finanssektoren og medicinsk diagnosticering er blot nogle af de områder, hvor mennesket helt eller delvist er ved at blive erstattet af avancerede machine learning-baserede systemer, der bliver bedre, jo mere de bliver brugt.

Machine learning bliver ofte koblet til den efterhånden gamle vision om kunstig intelligens. Sammen med billedet af "maskiner, der overtager kontrollen", har det rejst en række mere principielle spørgsmål, som har fyldt meget i den bredere debat om teknologien. Direktøren på Oxford University-instituttet Future of Humanity Institute, professor Nick Bostrom, var i et interview med The Guardian ude med noget nær dommedagsprofetier om menneskets undergang, når maskinerne bliver klogere end os og på evolutionær vis vil overtage verdensherredømmet fra mennesket.

Meget mindre dramatisk, men lidt i samme spor er Cathy O'Neil, matematiker på Harvard, som i sin bog "Weapons of Math Destructions" formulerer bekymringen for de ødelæggende konsekvenser, hvis man i for høj grad stoler på, at matematiske modeller kan anvendes til at tage beslutninger med store konsekvenser for det enkelte menneske.

Trussel mod transparensen

Denne debat er også taget op herhjemme, blandt andre af professor på IT-Universitetet Rasmus Pagh. Han peger i en artikel på itu.dk på, at der er en risiko for, at det kan gå ud over transparensen i beslutningsprocesserne i både offentligt og privat regi. Risikoen opstår, hvis vigtige afgørelser i stadig højere grad bliver taget på basis af så mange parametre og af så avancerede algoritmer, at kun et fåtal efterhånden vil kunne gennemskue dem.

Samme problemstilling peger Flemming Bjerke, bestyrelsesmedlem i IT-Politisk forening, på.

– Det er i forvejen meget svært for den enkelte at gennemskue dels hvilke data, der bliver indsamlet om en, dels hvad de bliver brugt til. Det problem vil bare blive større, jo mere vi lader machine learning-baserede systemer træffe afgørelser, da de indsamlede data dermed bliver brugt til stadig flere formål, siger han.

Ret til forklaring

Inden for offentlig forvaltning er der en skærpet problemstilling i forhold til transparens. Som borger har man et retskrav på at få en forståelig forklaring på en afgørelse, og hvordan kan man honorere det krav, hvis afgørelserne er taget af meget avancerede systemer, hvis præmisser er svære at gennemskue?

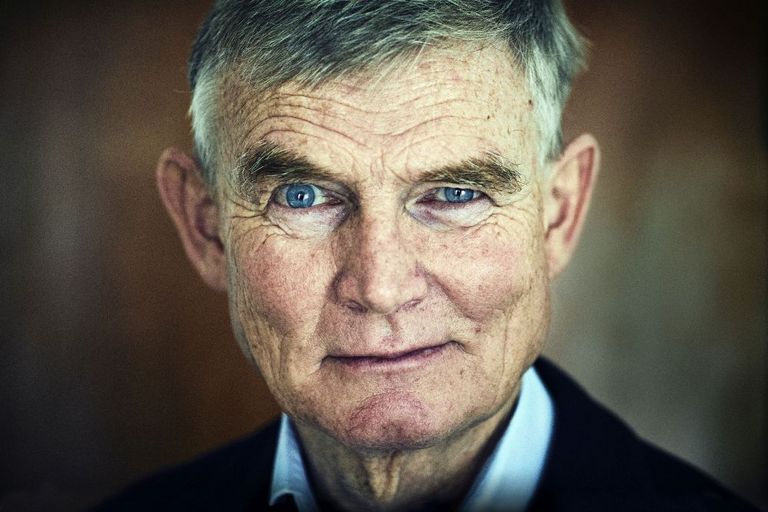

Automatiseret sagsbehandling er stadig i en meget tidlig fase i det offentlige, men Niels Fenger, professor i forvaltningsret ved Københavns Universitet, vurderer umiddelbart, at den eksisterende begrundelsespligt er tilstrækkelig også i en situation, hvor afgørelser bliver truffet af selvlærende systemer.

– Forvaltningen er vant til at skulle begrunde afgørelser, og hvis man ikke er i stand til at forklare en afgørelse, har man under alle omstændigheder et problem. Rent juridisk vil det i sidste ende jo stå og falde med, om afgørelsen er lovlig eller ej - ikke om det er en maskine eller et menneske, der har truffet den, siger han.

Hvem har ansvaret?

Udbredelsen af automatiserede løsninger, der "selv tager beslutninger", kan potentielt også udfordre hele spørgsmålet om ansvarsplacering, mener Henrik Udsen, professor i it-ret ved Københavns Universitet.

– Helt grundlæggende forudsætter vores lovgivning jo en eller anden form for menneskelige egenskaber og beslutningsprocesser. Det er jo den målestok, vi har været vant til at holde en given handling op imod. Og hvordan foretager man den vurdering, hvis det er en computer, der har taget beslutninger, som ligger længere og længere væk fra noget, et menneske har truffet beslutning om?, spørger han.

Henrik Udsen vurderer, at de nuværende regler for ansvarsplacering er tilstrækkelige, men vil ikke afvise, at det kan blive nødvendigt at justere dem på et tidspunkt.

– Vi ved jo reelt ikke, hvor teknologien ender. Hvor ligger ansvaret, hvis computerne begynder at tage beslutninger, som vi slet ikke kunne forudse, da vi bragte dem i anvendelse? Her bliver det i virkeligheden mindst lige så vigtigt at have tilstrækkelige kontrolprocedurer i forhold til, hvordan en given løsning udvikler sig, så man har mulighed for at justere på algoritmerne, siger han.

Ret til "menneskelig indgriben"

Den nye EU-persondataforordning, som træder i kraft 25. maj 2018, forholder sig til spørgsmålet om afgørelser, som baserer sig på en automatisk sagsbehandling. I artikel 71 hedder det, at man "bør have ret til ikke at blive gjort til genstand for en afgørelse, der kan omfatte en foranstaltning, som evaluerer personlige forhold vedrørende vedkommende, og som alene bygger på automatisk behandling, og som har retsvirkning, eller som på tilsvarende vis betydeligt påvirker den pågældende, såsom et automatisk afslag på en onlineansøgning om kredit eller e-rekrutteringsprocedurer uden nogen menneskelig indgriben". Til gengæld ligger der ikke noget krav om, at borgeren skal oplyses om, at en afgørelse er truffet i en automatiseret proces.

Risiko for bias

En risiko ved machine learning-baserede systemer, der ofte bliver peget på, er risikoen for diskrimination, når man anvender systemerne til profilering på basis af personoplysninger. Profilering er meget udbredt som middel til at målrette reklamekampagner, men bliver anvendt til en lang række andre formål. Et eksempel er en løsning fra det amerikanske firma Northpointe, som bliver anvendt i mange offentlige institutioner USA til at forudsige, hvem der på et tidspunkt bliver kriminelle – en løsning, som har en kraftig bias mod sorte.

Problemet er, at det ikke er muligt at få indsigt i, hvilke præmisser og hvilken model, som ligger til grund for de algoritmer, der bliver anvendt. Så ud over den diskrimination, der kunne være tale om, så illustrerer eksemplet en generel problemstilling i forhold til transparens: Mange algoritmer, der bliver anvendt i det offentlige, er ejet af private virksomheder, som ikke ønsker at offentliggøre de bagvedliggende modeller. Og selvom de gjorde, er der ifølge Ole Tange, it-politisk rådgiver i PROSA, stadig et problem:

– Selvom man gav borgerne adgang til at se, hvordan ”maskinen træffer beslutninger”, så kan dette være så komplekst, at man som menneske kan have meget svært ved at gennemskue det.

Handler om moral

Der bliver skrevet og sagt meget om, hvad machine learning-systemer efterhånden vil være i stand til. For Flemming Bjerke, IT-Politisk forening, er der et andet spørgsmål, som er meget vigtigere.

– Der er ingen grund til at tro, at denne type systemer ikke efterhånden vil kunne tage sig af opgaver, som vi i dag tror, at kun mennesker kan klare, Så det vigtige spørgsmål er, om vi overhovedet ønsker at sætte et system til at træffe vigtige afgørelser for mennesker. I praksis er det et problem for retssamfundet, siger han og fortsætter:

– Interesser, partsindlæg, tolkninger, vinklinger og uforudsigelighed findes jo stadig, selvom man bruger kunstig intelligens - uanset at den kunstige intelligens måske vil undertrykke det.

Cathy O'Neil gør også op med forestillingen om, at den bagvedliggende matematik i machine learning-systemer på nogen måde skulle være garant for neutralitet og objektivitet.

– I sidste ende handler det om moral, værdier og prioriteter. Grundlæggende er det et spørgsmål om moral, der bare bliver behandlet, som om det var matematik. Hvorfor? Fordi folk stoler på matematik. Hvis man kan pakke noget ind i matematik, vil folk holde op med at stille spørgsmål, siger hun i et interview i Politiken.

Altid en fall-back

Ole Tange ser også en risiko for, at den svagere part, typisk den enkelte borger, kan risikere at blive klemt.

– Machine learning vil kunne give fornuft i rigtigt mange forskellige situationer og kan formentlig være en god støtte for sagsbehandling. Men der skal altid være en fall-back i de sager, som af den ene eller anden grund falder uden for det, der kan rummes af den automatiserede løsning. Og det skal være en reel mulighed: Det må ikke bare være en teoretisk mulighed, som i praksis er uden for svage borgeres formåen, siger han og fortsætter:

– Til de uproblematiske sager kan man nok godt lave en 100 procent automatiseret behandling, men til mere komplekse sager vil jeg anbefale, at automatiseret sagsbehandling bliver en støtte for en sagsbehandling, hvor der også er et menneske inde over for at lave en vurdering. Maskinens rolle vil derfor blive reduceret til at finde de fakta, som underbygger en given beslutning, men det er mennesket, som baseret på disse fakta træffer beslutningen.

Fordele

Ensartethed og højere kvalitet er de to punkter, der typisk nævnes på plussiden i forhold til automatiserede sagsbehandlingsløsninger.

– Hvis systemet er lavet ordentligt, og man anvender det på noget, der er simpelt nok, kan det være en kæmpe fordel, da det kan sikre en ensartethed og kvalitet i sagsbehandlingen, måske ikke mindst i form af understøttende systemer, der gør sagsbehandleren opmærksom på vigtige forhold, siger Niels Fenger.

Flemming Bjerke mener også, at det vil give fin mening at sætte et system til at håndtere de mere rutineprægede afgørelser, og ensartethed i sagsbehandlingen ser han også som en fordel.

– Det kan godt være, at der er en risiko for systemmæssig bias mod en bestemt befolkningsgruppe. Modsat kan det jo også være et værn imod, at en sag uheldigvis bliver behandlet af en medarbejder, der har fordomme over for bestemte grupper, siger han.

Til gengæld giver han ikke meget for forestillingen om, at man vil nøjes med at lade systemerne være en støtte for en menneskelig sagsbehandler.

– For det første vil det ikke give mening at lade afgørelserne mellemlande på et sagsbehandlerbord, hvis systemerne rent faktisk er gode nok til at håndtere sagerne. For det andet viser erfaringerne, at hvis der kan laves besparelser gennem automatisering, så vil det blive gjort, siger Flemming Bjerke.